Жарознижувальні засоби для дітей призначаються педіатром. Але бувають ситуації невідкладної допомоги за лихоманки, коли дитині потрібно дати ліки негайно. Тоді батьки беруть на себе відповідальність і застосовують жарознижувальні препарати. Що можна давати дітям грудного віку? Чим можна збити температуру у старших дітей? Які ліки найбезпечніші?

У багатовимірному статистичному аналізі кожен об'єкт описується вектором, розмірність якого довільна (але та сама для всіх об'єктів). Проте людина може безпосередньо сприймати лише числові дані чи крапки на площині. Аналізувати скупчення точок у тривимірному просторі вже набагато складніше. Безпосереднє сприйняття даних вищої розмірності неможливе. Тому цілком природним є бажання перейти від багатовимірної вибірки до даних невеликої розмірності, щоби «на них можна було подивитися».

Крім прагнення наочності, є й інші мотиви зниження розмірності. Ті чинники, від яких дослідника змінна не залежить, лише заважають статистичного аналізу. По-перше, на збирання інформації про них витрачаються ресурси. По-друге, як можна довести, їхнє включення в аналіз погіршує властивості статистичних процедур (зокрема, збільшує дисперсію оцінок параметрів та характеристик розподілів). Тому бажано позбавитися таких чинників.

Обговоримо з погляду зниження розмірності приклад використання регресійного аналізу для прогнозування обсягу продажу, розглянутий у підрозділі 3.2.3. По-перше, у цьому прикладі вдалося скоротити кількість незалежних змінних з 17 до 12. По-друге, вдалося сконструювати новий фактор – лінійну функцію від 12 згаданих факторів, яка найкраще за інших лінійних комбінацій факторів прогнозує обсяг продажів. Тому можна сказати, що в результаті розмірність завдання зменшилася з 18 до 2. А саме залишився один незалежний фактор (наведена в підрозділі 3.2.3 лінійна комбінація) та один залежний – обсяг продажів.

При аналізі багатовимірних даних зазвичай розглядають не одну, а безліч завдань, зокрема по-різному вибираючи незалежні та залежні змінні. Тому розглянемо завдання зниження розмірності у наступному формулюванні. Дано багатовимірну вибірку. Потрібно перейти від неї сукупності векторів меншої розмірності, максимально зберігши структуру вихідних даних, по можливості не втрачаючи інформації, що містяться в даних. Завдання конкретизується у межах кожного конкретного методу зниження размерности.

Метод основних компонентє одним із найбільш часто використовуваних методів зниження розмірності. Основна його ідея полягає у послідовному виявленні напрямів, у яких дані мають найбільший розкид. Нехай вибірка складається з векторів, які однаково розподілені з вектором X = (x(1), x(2), … , x(n)). Розглянемо лінійні комбінації

Y(λ(1), λ(2), …, λ( n)) = λ(1) x(1) + λ(2) x(2) + … + λ( n)x(n),

λ 2 (1) + λ 2 (2) + …+ λ 2 ( n) = 1.

Тут вектор λ = (λ(1), λ(2), …, λ( n)) лежить на одиничній сфері в n-мірному просторі.

У способі основних компонент передусім знаходять напрям максимального розкиду, тобто. таке λ, при якому досягає максимуму дисперсія випадкової величини Y(λ) = Y(λ(1), λ(2), …, λ( n)). Тоді вектор λ задає першу головну компоненту, а величина Y(λ) є проекцією випадкового вектора Хна вісь першої головної компоненти.

Потім, висловлюючись термінами лінійної алгебри, розглядають гіперплощину n-мірному просторі, перпендикулярній першій головній компоненті, і проектують на цю гіперплощину всі елементи вибірки. Розмірність гіперплощини на 1 менша, ніж розмірність вихідного простору.

У аналізованій гіперплощині процедура повторюється. У ньому знаходять напрям найбільшого розкиду, тобто. другу головну компоненту. Потім виділяють гіперплощину, перпендикулярну першим двом головним компонентам. Її розмірність на 2 менша, ніж розмірність вихідного простору. Далі – наступна ітерація.

З погляду лінійної алгебри йдеться про побудову нового базису в n-мірному просторі, ортами якого є основні компоненти.

Дисперсія, що відповідає кожній новій головній компоненті, менша, ніж для попередньої. Зазвичай зупиняються, коли вона менша за заданий поріг. Якщо відібрано kголовних компонентів, то це означає, що від n-мірного простору вдалося перейти до k- мірному, тобто. скоротити розмірність з n-до k, практично не спотворивши структуру вихідних даних .

Для візуального аналізу даних часто використовують проекції вихідних векторів на площину перших двох основних компонентів. Зазвичай добре видно структуру даних, виділяються компактні кластери об'єктів і вектори, що окремо виділяються.

Метод головних компонент є одним із методів факторного аналізу. Різні алгоритми факторного аналізу об'єднані тим, що у всіх них відбувається перехід до нового базису у вихідному n-мірному просторі. Важливим є поняття «навантаження фактора», яке застосовується для опису ролі вихідного фактора (змінної) у формуванні певного вектора з нового базису.

Нова ідея проти методом головних компонент у тому, що у основі навантажень відбувається розбиття чинників групи. В одну групу поєднуються фактори, що мають подібний вплив на елементи нового базису. Потім із кожної групи рекомендується залишити одного представника. Іноді замість вибору представника розрахунковим шляхом формується новий фактор, що є центральним для групи, що розглядається. Зниження розмірності відбувається під час переходу до системи чинників, є представниками груп. Інші чинники відкидаються.

Описана процедура може бути здійснена не лише за допомогою факторного аналізу. Йдеться про кластер-аналіз ознак (чинників, змінних). Для розбиття ознак групи можна застосовувати різні алгоритми кластер-аналізу. Достатньо ввести відстань (міру близькості, показник відмінності) між ознаками. Нехай Хі У– дві ознаки. Відмінність d(X, Y) між ними можна вимірювати за допомогою вибіркових коефіцієнтів кореляції:

d 1 (X,Y) = 1 – r n(X,Y), d 2 (X,Y) = 1 - ρ n(X,Y),

де r n(X, Y) – вибірковий лінійний коефіцієнт кореляції Пірсона, ρ n(X, Y) - вибірковий коефіцієнт рангової кореляції Спірмена.

Багатомірне шкалювання. На використанні відстаней (заходів близькості, показників відмінності) d(X, Y) між ознаками Хі Узаснований великий клас методів багатовимірного шкалювання. Основна ідея цього класу методів полягає у поданні кожного об'єкта точкою геометричного простору (зазвичай розмірності 1, 2 або 3), координатами якої служать значення прихованих (латентних) факторів, які в сукупності досить адекватно описують об'єкт. У цьому відносини між об'єктами замінюються відносинами між точками – їх представниками. Так, дані про схожість об'єктів - відстанями між точками, дані про перевагу - взаємним розташуванням точок.

У практиці використовується ряд різних моделейбагатовимірного шкалювання. У всіх них постає проблема оцінки істинної розмірності факторного простору. Розглянемо цю проблему з прикладу обробки даних про подібність об'єктів з допомогою метричного шкалирования.

Нехай є nоб'єктів Про(1), Про(2), …, O(n), для кожної пари об'єктів Про(i), O(j) задана міра їх подібності s(i, j). Вважаємо, що завжди s(i, j) = s(j, i). Походження чисел s(i, j) немає значення для опису роботи алгоритму. Вони могли бути отримані або безпосереднім виміром, або з використанням експертів, або шляхом обчислення сукупності описових характеристик, або якось інакше.

У евклідовому просторі розглядаються nоб'єктів мають бути представлені конфігурацією nточок, причому як міра близькості точок-представників виступає евклідова відстань d(i, j) між відповідними точками. Ступінь відповідності між сукупністю об'єктів і сукупністю точок, що їх представляють, визначається шляхом зіставлення матриць подібності || s(i, j)|| та відстаней || d(i, j)||. Метричний функціонал схожості має вигляд

Геометричну конфігурацію треба вибирати так, щоб функціонал S досягав найменшого значення .

Зауваження.У неметричному шкалюванні замість близькості самих заходів близькості та відстаней розглядається близькість упорядкувань на безлічі заходів близькості та безлічі відповідних відстаней. Замість функціоналу Sвикористовуються аналоги рангових коефіцієнтів кореляції Спірмена та Кендала. Іншими словами, неметричне шкалювання виходить із припущення, що міри близькості виміряні у порядковій шкалі.

Нехай евклідовий простір має розмірність m. Розглянемо мінімум середнього квадрата помилки

![]() ,

,

де мінімум береться за всіма можливими конфігураціями nточок в m-мірному евклідовому просторі. Можна показати, що аналізований мінімум досягається на деякій конфігурації. Зрозуміло, що при зростанні mвеличина α m монотонно зменшується (точніше, не зростає). Можна показати, що за m > n- 1 вона дорівнює 0 (якщо s(i, j) – метрика). Для збільшення можливостей змістовної інтерпретації бажано діяти у просторі можливо меншої розмірності. Однак розмірність необхідно вибрати так, щоб точки представляли об'єкти без великих спотворень. Виникає питання: як оптимально вибирати розмірність, тобто. натуральне число m?

У межах детермінованого аналізу даних обґрунтованої відповіді це питання, певне, немає. Отже, необхідно вивчити поведінку α m у тих чи інших імовірнісних моделях. Якщо міри близькості s(i, j) є випадковими величинами, розподіл яких залежить від «справжньої розмірності» m 0 (і, можливо, від якихось параметрів), то можна в класичному математико-статистичному стилі ставити завдання оцінки m 0, шукати заможні оцінки і т.д.

Почнемо будувати імовірнісні моделі. Приймемо, що об'єкти є крапками в евклідовому просторі розмірності k, де kдосить велике. Те, що «справжня розмірність» дорівнює m 0 означає, що всі ці точки лежать на гіперплощині розмірності m 0 . Приймемо для визначеності, що сукупність точок, що розглядаються, являє собою вибірку з кругового нормального розподілу з дисперсією σ 2 (0). Це означає, що об'єкти Про(1), Про(2), …, O(n) є незалежними в сукупності випадковими векторами, кожен із яких будується як ζ(1) e(1) + ζ(2) e(2) + … + ζ( m 0)e(m 0), де e(1), e(2), … , e(m 0) – ортонормальний базис у підпросторі розмірності m 0 , в якому лежать розглянуті точки, а ζ(1), ζ(2), … , ζ( m 0) - незалежні в сукупності одновимірні нормальні випадкові величини з математичним очікуванням) та дисперсією σ 2 (0).

Розглянемо дві моделі отримання мір близькості s(i, j). У першій із них s(i, j) відрізняються від Евклідова відстані між відповідними точками через те, що точки відомі з спотвореннями. Нехай з(1),з(2), … , з(n) - Розглянуті точки. Тоді

s(i, j) = d(c(i) + ε( i), c(j) + ε( j)), i, j = 1, 2, … , n,

де d- Евклідова відстань між точками в k-мірному просторі, вектора ε(1), ε(2), … , ε( n) є вибіркою з кругового нормального розподілу в k-мірному просторі з нульовим математичним очікуванням та коварійною матрицею σ 2 (1) I, де I- одинична матриця. Іншими словами, ε( i) = η(1) e(1) + η(2) e(2) + … + η( k)e(k), де e(1), e(2), …, e(k) – ортонормальний базис у k-мірному просторі, а (η( i, t), i= 1, 2, …, n, t= 1, 2, …, k) – сукупність незалежних у сукупності одновимірних випадкових величин з нульовим математичним очікуванням та дисперсією σ 2 (1).

У другій моделі спотворення накладено безпосередньо на самі відстані:

s(i,j) = d(c(i), c(j)) + ε( i,j), i,j = 1, 2, … , n, i ≠ j,

де (ε( i, j), i, j = 1, 2, … , n) – незалежні в сукупності нормальні випадкові величини з математичним очікуванням) та дисперсією σ 2 (1).

У роботі показано, що для обох сформульованих моделей мінімум середнього квадрата помилки α m при n→ ∞ сходиться ймовірно до

f(m) = f 1 (m) + σ 2 (1) ( k – m), m = 1, 2, …, k,

Таким чином, функція f(m) лінійна на інтервалах і , причому на першому інтервалі вона меншає швидше, ніж на другому. Звідси випливає, що статистика

є заможною оцінкою справжньої розмірності m 0 .

Отже, з ймовірнісної теорії випливає рекомендація - як оцінку розмірності факторного простору використовувати m*. Зазначимо, що подібна рекомендація була сформульована як евристична одним із засновників багатовимірного шкалювання Дж. Краскалом. Він виходив із досвіду практичного використання багатовимірного шкалювання та обчислювальних експериментів. Імовірнісна теорія дозволила обґрунтувати цю евристичну рекомендацію.

| Попередня |

Анотація наукової статті з математики, автор наукової роботи - Орлов Олександр Іванович, Луценко Євген Веніамінович

Однією з «точок зростання» прикладної статистикиє методи зниження розмірності простору статистичних даних. Вони все частіше використовуються для аналізу даних у конкретних прикладних дослідженнях, наприклад, соціологічних. Розглянемо найперспективніші методи зниження розмірності. Метод основних компонентє одним із найбільш часто використовуваних методів зниження розмірності. Для візуального аналізу даних часто використовують проекції вихідних векторів на площину перших двох основних компонентів. Зазвичай добре видно структуру даних, виділяються компактні кластери об'єктів і вектори, що окремо виділяються. Метод основних компонентє одним із методів факторного аналізу. Нова ідея в порівнянні з шляхом основних компонентполягає в тому, що на основі навантажень відбувається розбиття факторів на групи. В одну групу поєднуються чинники, що мають подібний вплив на елементи нового базису. Потім із кожної групи рекомендується залишити одного представника. Іноді замість вибору представника розрахунковим шляхом формується новий фактор, що є центральним для групи, що розглядається. Зниження розмірності відбувається під час переходу до системи чинників, є представниками груп. Інші чинники відкидаються. На використанні відстаней (мір близькості, показників відмінності) між ознаками і заснований великий клас методів багатовимірного шкалювання. Основна ідея цього класу методів полягає у поданні кожного об'єкта точкою геометричного простору (зазвичай розмірності 1, 2 або 3), координатами якої служать значення прихованих (латентних) факторів, які в сукупності досить адекватно описують об'єкт. Як приклад застосування імовірнісно-статистичного моделювання та результатів статистики нечислових даних обґрунтуємо спроможність оцінки розмірності простору даних у багатовимірному шкалюванні, раніше запропонованої Фарбалом з евристичних міркувань Розглянуто ряд робіт з оцінювання розмірностей моделей(У регресійному аналізі та в теорії класифікації). Дано інформацію про алгоритми зниження розмірності в автоматизованому системно-когнітивному аналізі.

Схожі теми наукових праць з математики, автор наукової роботи - Орлов Олександр Іванович, Луценко Євген Веніамінович

-

Математичні методи у соціології за сорок п'ять років

-

Різноманітність об'єктів нечислової природи

-

Оцінювання параметрів: однокрокові оцінки краще оцінок максимальної правдоподібності

-

Прикладна статистика - стан та перспективи

2016 / Орлов Олександр Іванович -

Стан та перспективи розвитку прикладної та теоретичної статистики

2016 / Орлов Олександр Іванович -

Взаємозв'язок граничних теорем та методу Монте-Карло

2015 / Орлов Олександр Іванович -

Про розвиток статистики об'єктів нечислової природи

2013 / Орлов Олександр Іванович -

Точки зростання статистичних методів

2014 / Орлов Олександр Іванович -

Про нові перспективні математичні інструменти контролінгу

2015 / Орлов Олександр Іванович -

Відстань у просторах статистичних даних

2014 / Орлов Олександр Іванович

Один з "періодів зростання" applied statistics is methods of reducing the dimension of statistical data. Вони є сприятливо використані в analysis of data в specific applied research, так як sociology. We investigate the most promising методів до reduce the dimensionality. Загальними компонентами є один з найбільш загальних методів, що застосовуються до зменшення dimensionality. Для Visual Analysis of Data є використані проекти оригіналів векторів на плані перших двох основних компонентів. Зазвичай ці структури є чітко помітними, високоосвітленими компактними clusters об'єктів і окремо розташованими векторами. Основними компонентами є один метод factor analysis. Нова ідея factor analysis in comparison with method principal components is that, based on loads, factors breaks up into groups. У одній групі factors, новий factor is combined with similar impact on elements of the new basis. Така їхня група є сумісною з одним representative. Деякий час, усвідомлює, що виконати вибіркову оцінку, як новий фактор, що є центральною до групи в питанні. Зменшені dimension occurs при transition до системи factors, які є representatives of groups. Інші factory є discarded. Використовуючи дистанцію (проximity measures, indicators of differences) між features і extensive class are based methods of multidimensional scaling . Основною думкою цієї категорії методів є даний об'єкт, як пункт geometric space (зазвичай dimension 1, 2, or 3), які coordinates є значеннями висхідних (латентних) факторів, які поєднують, що надійно позначають предмет. Як приклад application of probabilistic and statistical modeling and results of statistics of nonnumerical data, we justify the consistency of estimators of dimension of the data in multidimensional scaling , which are proposed previously by Kruskal from heuristic considerations. Вони були визначені в рядку послідовних вимірів dimension of models (in regression analysis and in theory of classification). We also give some information o algoritms for reduce the dimensionality in the automated system-cognitive analysis

Текст наукової роботи на тему «Методи зниження розмірності простору статистичних даних»

УДК 519.2: 005.521:633.1:004.8

01.00.00 Фізико-математичні науки

МЕТОДИ ЗНИЖЕННЯ РОЗМІРНОСТІ ПРОСТОРУ СТАТИСТИЧНИХ ДАНИХ

Орлов Олександр Іванович

д.е.н., д.т.н., к.ф.-м.н., професор

РІНЦ БРШ-код: 4342-4994

Московський державний технічний

університет ім. н.е. Баумана, Росія, 105005,

Москва, 2-а Бауманська вул., 5, [email protected]т

Луценко Євген Веніамінович д.е.н., к.т.н., професор РІНЦ БРШ-код: 9523-7101 Кубанський державний аграрний університет, Краснодар, Росія [email protected] com

Однією з точок зростання прикладної статистики є методи зниження розмірності простору статистичних даних. Вони все частіше використовуються для аналізу даних у конкретних прикладних дослідженнях, наприклад, соціологічних. Розглянемо найперспективніші методи зниження розмірності. Метод головних компонент одна із найчастіше використовуваних методів зниження размерности. Для візуального аналізу даних часто використовують проекції вихідних векторів на площину перших двох основних компонентів. Зазвичай добре видно структуру даних, виділяються компактні кластери об'єктів і вектори, що окремо виділяються. Метод основних компонент одна із методів факторного аналізу. Нова ідея проти методом головних компонент у тому, що у основі навантажень відбувається розбиття чинників групи. В одну групу поєднуються фактори, що мають подібний вплив на елементи нового базису. Потім із кожної групи рекомендується залишити одного представника. Іноді замість вибору представника розрахунковим шляхом формується новий фактор, що є центральним для групи, що розглядається. Зниження розмірності відбувається під час переходу до системи чинників, є представниками груп. Інші чинники відкидаються. На використанні відстаней (заходів близькості, показників відмінності) між ознаками і заснований великий клас методів багатовимірного шкалювання. Основна ідея цього класу методів полягає у поданні кожного об'єкта точкою геометричного простору (зазвичай розмірності 1, 2 або 3), координатами якої є значення прихованих (латентних) факторів, які в сукупності досить адекватно описують

UDC 519.2: 005.521:633.1:004.8

Physics and mathematical sciences

METHODS OF REDUCING SPACE DIMENSION OF STATISTICAL DATA

Orlov Alexander Ivanovich

Dr.Sci.Econ., Dr.Sci.Tech., Cand.Phys-Math.Sci.,

Bauman Moscow State Technical University, Москва, Росія

Lutsenko Eugeny Veniaminovich Dr.Sci.Econ., Cand.Tech.Sci., profesor RSCI SPIN-код: 9523-7101

Kuban State Agrarian University, Краснодар, Росія

Один з "періодів зростання" applied statistics is methods of reducing the dimension of statistical data. Вони є сприятливо використані в analysis of data в specific applied research, так як sociology. We investigate the most promising методів до reduce the dimensionality. Загальні компоненти є одним з найбільш загальних методів, що застосовуються до зменшення dimensionality. Для Visual Analysis of Data є використані проекти оригіналів векторів на плані перших двох основних компонентів. Зазвичай ці структури є чітко помітними, високоосвітленими компактними clusters об'єктів і окремо виділеними векторами. Головними компонентами є один метод factor analysis. Нова ідея factor analysis in comparison with method of principal components is that, based on loads, factors breaks up into groups. У одній групі factors, новий factor is combined with similar impact on elements of the new basis. Така їхня група є сумісною з одним representative. Деякий час, усвідомлює, що виконати вибіркову оцінку, як новий фактор, що є центральною до групи в питанні. Зменшені dimension occurs при transition до системи factors, які є representatives of groups. Інші factory є discarded. Використовуючи дистанцію (пропорційність параметрів, показники різниці) між рисами і основними класами є базовані методи multidimensional scaling. Основною думкою цієї категорії методів є даний об'єкт, як пункт geometric space (зазвичай dimension 1, 2, or 3), які coordinates є значеннями висхідних (латентних) факторів, які поєднують, що надійно позначають предмет. Як приклад application of probabilistic and statistical modeling and results of statistics of non-numeric data, we justify the consistency of estimators of the

об'єкт. Як приклад застосування імовірнісно-статистичного моделювання та результатів статистики нечислових даних обґрунтуємо спроможність оцінки розмірності простору даних у багатовимірному шкалюванні, раніше запропонованої Фарбалом з евристичних міркувань. Розглянуто ряд робіт з оцінювання розмірностей моделей (у регресійному аналізі та теорії класифікації). Дано інформацію про алгоритми зниження розмірності в автоматизованому системно-когнітивному аналізі.

Ключові слова: МАТЕМАТИКА, ПРИКЛАДНА СТАТИСТИКА, МАТЕМАТИЧНА СТАТИСТИКА, ТОЧКИ ЗРОСТАННЯ, МЕТОД ГОЛОВНИХ КОМПОНЕНТ, ФАКТОРНИЙ АНАЛІЗ, БАГАТОМІРНЕ ШКАЛЮВАННЯ, ОЦІНЮВАННЯ РОЗДІЛЕННЯ, ОЦІНЮВАННЯ РОЗДІЛУВАННЯ

dimension of the data in multidimensional scaling, which are proposed previously by Kruskal from heuristic considerations. Вони були визначені в рядку послідовних вимірів dimension of models (in regression analysis and in theory of classification). We also give some information o algoritms for reduce the dimensionality in the automated system-cognitive analysis

Ключові слова: MATHEMATICS, APPLIED STATISTICS, MATHEMATICAL STATISTICS, GROWTH POINTS, THE PRINCIPAL COMPONENT ANALYSIS, FACTOR ANALYSIS, MULTIDIMENSIONAL SCALING, ESTIMATION OF DATA DIMENSION, ESTIMATION OF MODELDI

1. Введення

Як зазначалося, однією з «точок зростання» прикладної статистики є методи зниження розмірності простору статистичних даних. Вони все частіше використовуються для аналізу даних у конкретних прикладних дослідженнях, наприклад, соціологічних. Розглянемо найперспективніші методи зниження розмірності. Як приклад застосування імовірнісно-статистичного моделювання та результатів статистики нечислових даних обґрунтуємо спроможність оцінки розмірності простору, раніше запропонованої Фарбалом з евристичних міркувань.

У багатовимірному статистичному аналізі кожен об'єкт описується вектором, розмірність якого довільна (але та сама для всіх об'єктів). Проте людина може безпосередньо сприймати лише числові дані чи крапки на площині. Аналізувати скупчення точок у тривимірному просторі вже набагато складніше. Безпосереднє сприйняття даних вищої розмірності неможливе. Тому цілком природним є бажання перейти від багатовимірної вибірки до даних невеликої розмірності, щоби «на них можна було

подивитися». Наприклад, маркетолог може наочно побачити, скільки є різних типівповедінки споживачів (тобто скільки доцільно виділяти сегментів ринку) та які саме (з якими властивостями) споживачі до них входять.

Крім прагнення наочності, є й інші мотиви зниження розмірності. Ті чинники, від яких дослідника змінна не залежить, лише заважають статистичного аналізу. По-перше, на збирання інформації про них витрачаються фінансові, тимчасові, кадрові ресурси. По-друге, як можна довести, їхнє включення в аналіз погіршує властивості статистичних процедур (зокрема, збільшує дисперсію оцінок параметрів та характеристик розподілів). Тому бажано позбавитися таких чинників.

При аналізі багатовимірних даних зазвичай розглядають не одну, а безліч завдань, зокрема по-різному вибираючи незалежні та залежні змінні. Тому розглянемо завдання зниження розмірності у наступному формулюванні. Дано багатовимірну вибірку. Потрібно перейти від неї сукупності векторів меншої розмірності, максимально зберігши структуру вихідних даних, по можливості не втрачаючи інформації, що містяться в даних. Завдання конкретизується у межах кожного конкретного методу зниження размерности.

2. Метод основних компонент

Він є одним із найбільш часто використовуваних методів зниження розмірності. Основна його ідея полягає у послідовному виявленні напрямів, у яких дані мають найбільший розкид. Нехай вибірка складається з векторів, що однаково розподілені з вектором X = (x(1), x(2), ... , x(n)). Розглянемо лінійні комбінації

7(^(1), Х(2), ., l(n)) = X(1)x(1) + X(2)x(2) + ... + l(n)x(n) ,

Х2(1) + Х2(2) + ...+ Х2(п) = 1. Тут вектор X = (Х(1), Х(2), ..., Х(п)) лежить на одиничній сфері п-вимірному просторі.

У способі основних компонентів передусім знаходять напрям максимального розкиду, тобто. таке X, у якому досягає максимуму дисперсія випадкової величини 7(Х) = 7(Х(1), Х(2), ..., Х(п)). Тоді вектор X визначає першу головну компоненту, а величина 7(Х) є проекцією випадкового вектора Х на вісь першої головної компоненти.

Потім, висловлюючись термінами лінійної алгебри, розглядають гіперплощину в п-мірному просторі, перпендикулярну першій головній компоненті, і проектують на цю гіперплощину всі елементи вибірки. Розмірність гіперплощини на 1 менше, ніж розмірність вихідного простору.

У аналізованій гіперплощині процедура повторюється. У ньому знаходять напрям найбільшого розкиду, тобто. другу головну компоненту. Потім виділяють гіперплощину, перпендикулярну першим двом головним компонентам. Її розмірність на 2 менша, ніж розмірність вихідного простору. Далі – наступна ітерація.

З погляду лінійної алгебри йдеться про побудову нового базису в п-мірному просторі, ортами якого є основні компоненти.

Дисперсія, що відповідає кожній новій головній компоненті, менша, ніж для попередньої. Зазвичай зупиняються, коли вона менша за заданий поріг. Якщо відібрано до основних компонент, це означає, що з п-мерного простору вдалося перейти до к-мерному, тобто. скоротити розмірність з п-до, практично не спотворивши структуру вихідних даних.

Для візуального аналізу даних часто використовують проекції вихідних векторів на площину перших двох основних компонентів. Зазвичай

добре видно структуру даних, виділяються компактні кластери об'єктів і окремі вектори.

3. Факторний аналіз

Метод головних компонент одна із методів факторного аналізу. Різні алгоритми факторного аналізу об'єднані тим, що в них відбувається перехід до нового базису у вихідному n-мірному просторі. Важливим є поняття «навантаження фактора», яке застосовується для опису ролі вихідного фактора (змінної) у формуванні певного вектора з нового базису.

Нова ідея проти методом головних компонент у тому, що у основі навантажень відбувається розбиття чинників групи. В одну групу поєднуються чинники, що мають подібний вплив на елементи нового базису. Потім із кожної групи рекомендується залишити одного представника. Іноді замість вибору представника розрахунковим шляхом формується новий фактор, що є центральним для групи, що розглядається. Зниження розмірності відбувається під час переходу до системи чинників, є представниками груп. Інші чинники відкидаються.

Описана процедура може бути здійснена не лише за допомогою факторного аналізу. Йдеться про кластер-аналіз ознак (чинників, змінних). Для розбиття ознак групи можна застосовувати різні алгоритми кластер-аналізу . Достатньо ввести відстань (міру близькості, показник відмінності) між ознаками. Нехай Х та У – дві ознаки. Відмінність d(X,Y) між ними можна вимірювати за допомогою вибіркових коефіцієнтів кореляції:

di(X,Y) = 1 - \rn(X,Y)\, d2(X,Y) = 1 - \pn(X,Y)\, де rn(X,Y) - вибірковий лінійний коефіцієнт кореляції Пірсона, pn(X, Y) - вибірковий коефіцієнт рангової кореляції Спірмена.

4. Багатомірне шкалювання.

На використанні відстаней (мір близькості, показників відмінності) d(X,Y) між ознаками Х і У заснований великий клас методів багатовимірного шкалювання. Основна ідея цього класу методів полягає у поданні кожного об'єкта точкою геометричного простору (зазвичай розмірності 1, 2 або 3), координатами якої служать значення прихованих (латентних) факторів, які в сукупності досить адекватно описують об'єкт. При цьому відносини між об'єктами замінюються відносинами між точками – їх представниками. Так, дані про схожість об'єктів - відстанями між точками, дані про перевагу - взаємним розташуванням точок.

5. Проблема оцінки справжньої розмірності факторного простору

У практиці аналізу соціологічних даних використовують ряд різних моделей багатовимірного шкалювання. У всіх них постає проблема оцінки справжньої розмірності факторного простору. Розглянемо цю проблему з прикладу обробки даних про подібність об'єктів з допомогою метричного шкалирования.

Нехай є n об'єктів 0(1), О(2), ..., O(n), кожної пари об'єктів 0(/), O(j) задана міра їх подібності s(ij). Вважаємо, що s(i,j) = s(j,i). Походження чисел s(ij) не має значення для опису роботи алгоритму. Вони могли бути отримані або безпосереднім виміром, або з використанням експертів, або шляхом обчислення за сукупністю описових характеристик або якось інакше.

У евклідовому просторі розглянуті n об'єктів повинні бути представлені конфігурацією n точок, причому як міра близькості точок-представників виступає евклідова відстань d(i,j)

між відповідними точками. Ступінь відповідності між сукупністю об'єктів і сукупністю точок, що їх представляють, визначається шляхом зіставлення матриць подібності ||я(,)|| та відстаней ШМ-Метричний функціонал подібності має вигляд

я = £|*(/, ]) - й (/, М

Геометричну конфігурацію треба вибирати так, щоб функціонал S досягав найменшого значення .

Зауваження. У неметричному шкалюванні замість близькості самих заходів близькості та відстаней розглядається близькість упорядкувань на безлічі заходів близькості та безлічі відповідних відстаней. Замість функціоналу S використовуються аналоги рангових коефіцієнтів кореляції Спірмена та Кендала. Іншими словами, неметричне шкалювання виходить із припущення, що міри близькості виміряні у порядковій шкалі.

Нехай евклідовий простір має розмірність т. Розглянемо мінімум середнього квадрата помилки

де мінімум береться за всіма можливими конфігураціями пунктів у т-мірному евклідовом просторі. Можна показати, що аналізований мінімум досягається на деякій конфігурації. Ясно, що при зростанні т величина ат монотонно зменшується (точніше, не зростає). Можна показати, що при т > п – 1 вона дорівнює 0 (якщо – метрика). Для збільшення можливостей змістовної інтерпретації бажано діяти у просторі можливо меншої розмірності. Однак розмірність необхідно вибрати так, щоб точки представляли об'єкти без великих спотворень. Виникає питання: як оптимально вибирати розмірність простору, тобто. натуральне число т?

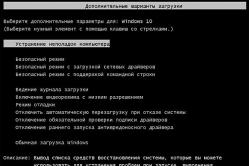

6. Моделі та методи оцінювання розмірності простору даних

У межах детермінованого аналізу даних обґрунтованої відповіді це питання, певне, немає. Отже, необхідно вивчити поведінку am у тих чи інших імовірнісних моделях. Якщо міри близькості s(ij) є випадковими величинами, розподіл яких залежить від «істинної розмірності» m0 (і, можливо, від будь-яких параметрів), то можна в класичному математико-статистичному стилі ставити завдання оцінки m0, шукати заможні оцінки і і т.д.

Почнемо будувати імовірнісні моделі. Приймемо, що об'єкти є крапками в евклідовому просторі розмірності до, де досить велика. Те, що «справжня розмірність» дорівнює m0, означає, що всі ці точки лежать на гіперплощині розмірності m0. Приймемо для визначеності, що сукупність точок, що розглядаються, являє собою вибірку з кругового нормального розподілу з дисперсією про (0). Це означає, що об'єкти 0(1), 0(2), ..., O(n) є незалежними в сукупності випадковими векторами, кожен із яких будується як

Z(1)e(1) + Z(2)e(2) + ... + Z(m0)e(m0), де e(1), e(2), ... , e(m0) - ортонормальний базис у підпросторі розмірності m0, в якому лежать розглянуті точки, а Z(1), Z(2), Z(m0) - незалежні в сукупності одновимірні нормальні випадкові величини з математичним очікуванням 0 і дисперсією про (0).

Розглянемо дві моделі одержання заходів близькості s(ij). У першій з них s(ij) відрізняються від евклідової відстані між відповідними точками через те, що точки відомі з спотвореннями. Нехай с(1), с(2), ... , c(n) - точки, що розглядаються. Тоді

s(i,j) = d(c(i) + e(i), c(j) + s(/)), ij = 1, 2, ..., n,

де й - евклідова відстань між точками в ^мірному просторі, вектора е(1), е(2), ... , е(п) являють собою вибірку з кругового нормального розподілу в ^мірному просторі з нульовим математичним очікуванням і матриці коварійної про (1)/, де I-поодинока матриця. Іншими словами,

е(0 = п(1)е(1) + П(2)е(2) + ... + ц(к)в(к), де е(1), е(2), ..., e(k) - ортонормальний базис в ^мірному просторі, а [ц^^), i = 1, 2, ..., п,? =1, 2, ..., к) - сукупність незалежних у сукупності одновимірних випадкових величин з нульовим математичним очікуванням та дисперсією про (1).

У другій моделі спотворення накладено безпосередньо на самі відстані:

Кч) = й(Ф\ СІ)) + £(УХ і = 1, 2., n, i ф j,

де і , причому першому інтервалі вона меншає швидше, ніж другому. Звідси випливає, що статистика

m* = Arg minam+1 - 2am + an-x)

є спроможною оцінкою істинної розмірності m0.

Отже, з ймовірнісної теорії випливає рекомендація - як оцінку розмірності факторного простору використовувати т *. Зазначимо, що подібна рекомендація була сформульована як евристична одним із засновників багатовимірного шкалювання Дж. Краскалом. Він виходив із досвіду практичного використання багатовимірного шкалювання та обчислювальних експериментів. Імовірнісна теорія дозволила обґрунтувати цю евристичну рекомендацію.

7. Оцінювання розмірності моделі

Якщо можливі підмножини ознак утворюють сімейство, що розширюється, наприклад, оцінюється ступінь полінома, то природно ввести термін «розмірність моделі» (це поняття багато в чому аналогічно використовуваному в багатовимірному шкалюванні поняття розмірності простору даних). Автору цієї статті належить ряд робіт з оцінювання розмірності моделі, які доцільно зіставити з роботами з оцінювання розмірності простору даних, розглянутими вище.

Перша така робота виконана автором цієї статті під час відрядження до Франції в 1976 р. У ній була вивчена одна оцінка розмірності моделі в регресії, а саме оцінка ступеня полінома в припущенні, що залежність описується поліномом. Ця оцінка була відома в літературі, але пізніше її стали помилково приписувати автору цієї статті, який лише вивчив її властивості, зокрема встановив, що вона не є заможною, і знайшов її граничний геометричний розподіл. Інші, вже заможні оцінки розмірності регресійної моделі були запропоновані та вивчені у статті. Цей цикл завершила робота, що містить ряд уточнень.

Крайня публікація на цю тему включає обговорення результатів вивчення швидкості збіжності в отриманих мною граничних теоремах методом Монте-Карло.

Аналогічні за методологією оцінки розмірності моделі в задачі розщеплення сумішей (частина теорії класифікації) розглянуті у статті.

Розглянуті вище оцінки розмірності моделі у багатовимірному шкалюванні вивчаються на роботах. У цих роботах встановлено граничне поведінка показників методу основних компонент (з допомогою асимптотичної теорії поведінки рішень екстремальних статистичних завдань ).

8. Алгоритми зниження розмірності в автоматизованому системно-когнітивному аналізі

В автоматизованому системно-когнітивному аналізі (АСК-аналізі) запропоновано і в системі "Ейдос" реалізовано ще один метод зниження розмірності. Він описаний у роботі у розділах 4.2 "Опис алгоритмів базових когнітивних операцій системного аналізу (БКОСА)" та 4.3 "Детальні алгоритми БКОСА (АСК-аналізу)". Наведемо короткий опис двох алгоритмів – БКОСА-4.1 та БКОСА-4.2.

БКОСА-4.1. "Абстрагування факторів (зниження розмірності семантичного простору факторів)"

За допомогою методу послідовних наближень (ітераційний алгоритм) за заданих граничних умов знижується розмірність простору атрибутів без істотного зменшення його обсягу. Критерій зупинення ітераційного процесу - досягнення однієї з граничних умов.

БКОСА-4.2. "Абстрагування класів (зниження розмірності семантичного простору класів)"

За допомогою методу послідовних наближень (ітераційний алгоритм) за заданих граничних умов знижується розмірність простору класів без істотного зменшення його обсягу. Критерій зупинення ітераційного процесу - досягнення однієї з граничних умов.

Тут наведено всі реальні алгоритми, реалізовані в системі "Ейдос" тієї версії, яка була реалізована на момент підготовки роботи (2002 рік): http://lc.kubagro .ru/aidos/aidos02/4.3 .htm

Суть алгоритмів така.

1. Розраховується кількість інформації у значеннях факторів про перехід об'єкта у стани, що відповідають класам.

2. Розраховується цінність значення чинника для диференціації об'єкта за класами. Ця цінність - це варіабельність інформативностей значень чинників (кількісних заходів варіабельності багато: середнє відхилення від середнього, середнє квадратичне відхилення, та інших.). Інакше кажучи, якщо в значенні фактора в середньому міститься мало інформації про належність і не належність об'єкта до класу, то це значення не дуже цінне, а якщо багато цінне.

3. Розраховується цінність описових шкал для диференціації об'єктів за класами. У роботах Є.В. Луценко сьогодні це робиться як середнє від цінностей градацій цієї шкали.

4. Потім проводиться Парето-оптимізація значень факторів та описових шкал:

Значення факторів (градації описових шкал) ранжуються в порядку зменшення цінності і видаляються з моделі ті найменш цінні, які йдуть правіше дотичної до Парето-кривої 45°;

Фактори (описові шкали) ранжуються в порядку зменшення цінності і видаляються з моделі ті найменш цінні, які йдуть правіше дотичної до Парето-кривої 45°.

Через війну розмірність простору, побудованого на описових шкалах, істотно знижується з допомогою видалення корелюючих між собою шкал, тобто. по суті, це ортонормування простору в інформаційній метриці.

Цей може повторюватися, тобто. бути ітераційним, при цьому в нової версіїВ системі "Ейдос" ітерації запускаються вручну.

Аналогічно ортонормується інформаційний простір класів.

Шкали та його градації може бути числовими (тоді обробляються інтервальні значення), і навіть можуть бути текстовими (порядковими і навіть номінальними).

Таким чином, за допомогою алгоритмів БКОСА (АСК-аналізу) розмірність простору максимально знижується з мінімальною втратою інформації.

Для аналізу статистичних даних у прикладній статистиці розроблено низку інших алгоритмів зниження розмірності. До завдань цієї статті не входить опис всього різноманіття таких алгоритмів.

Література

1. Орлов А.І. Точки зростання статистичних методів // Політематичний мережевий електронний науковий журналКубанського державного аграрного університету. 2014. № 103. С. 136-162.

2. Фаркал Дж. Взаємозв'язок між багатовимірним шкалюванням та кластер-аналізом // Класифікація та кластер. М: Світ, 1980. С.20-41.

4. Харман Г. Сучасний факторний аналіз. М: Статистика, 1972. 489 з.

5. Орлов А.І. Нотатки з теорії класифікації. / Соціологія: методологія, методи, математичні моделі. 1991. № 2. С.28-50.

6. Орлов А.І. Базові результати математичної теорії класифікації // Політематичний мережевий електронний науковий журнал Кубанського державного аграрного університету. 2015. № 110. С. 219-239.

7. Орлов А.І. Математичні методи теорії класифікації // Політематичний мережевий електронний науковий журнал Кубанського державного аграрного університету. 2014. № 95. С. 23 – 45.

8. Терьохіна А.Ю. Аналіз даних методами багатовимірного шкалювання. -М: Наука, 1986. 168 с.

9. Перехрест В. Т. Нелінійний типологічний аналіз соціально-економічної інформації: Математичні та обчислювальні методи. - Л.: Наука, 1983. 176 с.

10. Тюрін Ю.М., Литвак Б.Г., Орлов А.І., Сатаров Г.А., Шмерлінг Д.С. Аналіз нечислової інформації. М.: Наукова Рада АН СРСР із комплексної проблеми "Кібернетика", 1981. - 80 с.

11. Орлов А.І. Загальний погляд на статистику об'єктів нечислової природи// Аналіз нечислової інформації в соціологічних дослідженнях. - М: Наука, 1985. С.58-92.

12. Орлов А.І. Граничний розподіл однієї оцінки числа базисних функцій у регресії // Прикладний статистичний багатовимірний аналіз. Вчені записки зі статистики, т.33. - М: Наука, 1978. С.380-381.

13. Орлов А.І. Оцінка розмірності моделі в регресії // Алгоритмічне та програмне забезпеченняприкладного статистичного аналізу Вчені записки зі статистики, т.36. - М: Наука, 1980. С.92-99.

14. Орлов А.І. Асимптотика деяких оцінок розмірності моделі у регресії // Прикладна статистика. Вчені записки зі статистики, т.45. - М: Наука, 1983. С.260-265.

15. Орлов А.І. Про оцінювання регресійного полінома // Заводська лабораторія. Діагностика матеріалів. 1994. Т.60. №5. С.43-47.

16. Орлов А.І. Деякі ймовірні питання теорії класифікації // Прикладна статистика. Вчені записки зі статистики, т.45. - М: Наука, 1983. С.166-179.

17. Orlov A.I. На розробці статей з nonnumerical objects // Design of Experiments and Data Analysis: New Trends and Results. – M.: ANTAL, 1993. Р.52-90.

18. Орлов А.І. Методи зниження розмірності// Додаток 1 до книги: Толстова Ю.М. Основи багатовимірного шкалювання: Навчальний посібникдля вузів. – М.: Видавництво КДУ, 2006. – 160 с.

19. Орлов А.І. Асимптотика рішень екстремальних статистичних завдань// Аналіз нечислових даних у системних дослідженнях. Збірник праць. Вип. 10. - М: Всесоюзний науково-дослідний інститут системних досліджень, 1982. С. 412.

20. Орлов А.І. Організаційно-економічне моделювання: підручник: о 3 год. Частина 1: Нечислова статистика. - М: Вид-во МДТУ ім. н.е. Баумана. – 2009. – 541 с.

21. Луценко Є.В. Автоматизований системно-когнітивний аналіз в управлінні активними об'єктами (системна теорія інформації та її застосування у дослідженні економічних, соціально-психологічних, технологічних та організаційно-технічних систем): Монографія (наукове видання). -Краснодар: КубДАУ. 2002. – 605 с. http://elibrary.ru/item.asp?id=18632909

1. Orlov A.I. Tochki rosta statisticheskich metod // Politematicheskij setevej jelektronny nauchny zhurnal Kubanskogogosudarstvennogo agrarnogo universiteta. 2014. № 103. S. 136-162.

2. Краскаль Дж. Взаімосвяж" між багатомірним шкаліруванням і кластер-аналізом // Класифікація і кластер. М.: Mir, 1980. S.20-41.

3. Kruskal J.B., Wish M. Multidimensional scaling // Sage University paper series: Qualitative applications in the social sciences. 1978. №11.

4. Harman G. Сучасний факторний аналіз. M.: Statistika, 1972. 489 s.

5. Orlov A.I. Замітки по теорії класифікації. / Sociologija: metodologija, metody, matematicheskie modeli. 1991. № 2. S.28-50.

6. Orlov A.I. Базові ресурси математичної теорії класіфікації // Поліматичний сетевий електроновий науковий журнал Кубанського державного агарного університету. 2015. № 110. S. 219-239.

7. Orlov A.I. Математичні методи теорії класифікації // Політематичний сетевий електроновий науковий журнал Кубанського державного агарного університету. 2014. № 95. S. 23 – 45.

8. Terehina A.Ju. Аналіз даних методами багатогомерного шкалірування. - M: Nauka, 1986. 168 s.

9. Perekrest V.T. Нелінійний топологічний аналіз соціальної "но-еekonomicкої інформації: Matematicheskie і вичіслітельные" методи. - L.: Nauka, 1983. 176 с.

10. Tjurin Ju.N., Litvak B.G., Orlov A.I., Satarov G.A., Shmerling D.S. Analiz nechislovoj informacii. М.: Научний Совет в SSSR по комплексній проблемі "Кібернетика", 1981. - 80 с.

11. Orlov A.I. Обшій виходив на сtatistikу об'ектів нехислової природи // Аналіз нехислової інформації в соціологічних дослідженнях. - M.: Nauka, 1985. S.58-92.

12. Orlov A.I. Поділ "не розповсюдження однієї основи чисела фундаментальних функцій в регресії // Прихідний багатомірний статистичний аналіз.

13. Orlov A.I. Центр розмірності моделі в регресії // Алгоритмическое і programmnoe обтяження основного статистичного аналітика. Учені заpiski по statistice, t.36. - M.: Nauka, 1980. S.92-99.

14. Orlov A.I. Asimptotika nekotoryh ocenok razmernosti modeli в регресії // Prikladna statistika. Вчені заpiski по statistike, t.45. - M.: Nauka, 1983. S.260-265.

15. Orlov A.I. Об отенізації регресійного полінома // Заводська laboratoria. Діагностика матеріалів. 1994. T.60. №5. S.43-47.

16. Orlov A.I. Некоторие віроятностние вопроси teorii klasifikacii / / Prikladna statistika. Вчені заpiski по statistike, t.45. - M.: Nauka, 1983. S.166-179.

17. Orlov A.I. На розробці статей з nonnumerical objects // Design of Experiments and Data Analysis: New Trends and Results. – M.: ANTAL, 1993. R.52-90.

18. Orlov A.I. Методи сниженія розмірності // Приложение 1 до книги: Толстова Ю.Н. Основное многомерное шкалірування: Учебний спосіб для вузов. - M.: Izdatel"stvo KDU, 2006. - 160 s.

19. Orlov A.I. Asimptotika reshenij jekstremal"них statisticheskich zadach // Analiz nechislovych dannych v sistemnyh issledovaniyah. Sbornik trudov. Vyp.10. - M.: Vsesojuznyy науко-issledovatel"skij institut sistemnys issledovan2.

20. Orlov A.I. Організаційно-йоekonomichee моделювання: uchebnik: v 3 ch. Chast" 1: Nechislovaja statistika. - M.: Izd-vo MGTU im. N.Je. Baumana. - 2009. - 541 s.

21. Lucenko E.V. Автоматизований системно-когнітивний аналіз в управлінні активними об#ектами (системна теорія інформації і її застосування в дослідженнях економетричних, соціально-психологічних, технологічних). 605 s. http://elibrary.ru/item.asp?id=18632909

Зниження розмірності (Data reduction)

В аналітичних технологіях під зниженням розмірності даних розуміється процес їх перетворення на форму, найбільш зручну для аналізу та інтерпретації. Зазвичай воно досягається рахунок зменшення їх обсягу, скорочення кількості використовуваних ознак і розмаїття їх значень.

Часто аналізовані дані є неповними, коли вони погано відображають залежності та закономірності досліджуваних бізнес-процесів. Причинами цього може бути недостатня кількість спостережень, відсутність ознак, які відбивають суттєві властивості об'єктів. У цьому випадку застосовується збагачення даних.

Зниження розмірності застосовується у протилежному випадку, коли дані надмірні. Надмірність виникає тоді, коли завдання аналізу можна вирішити з тим самим рівнем ефективності та точності, але використовуючи меншу розмірність даних. Це дозволяє скоротити час та обчислювальні витрати на розв'язання задачі, зробити дані та результати їх аналізу більш інтерпретованими та зрозумілими для користувача.

Скорочення числа спостережень даних застосовується якщо рішення порівнянної якості можна отримати на вибірці меншого обсягу, скоротивши тим самим обчислювальні та тимчасові витрати. Особливо це актуально для алгоритмів, що не масштабуються, коли навіть невелике скорочення числа записів призводить до суттєвого виграшу в обчислювальних часових витратах.

Скорочення числа ознак має сенс проводити тоді, коли інформація, необхідна для якісного вирішення завдання, міститься в деякому підмножині ознак і необов'язково використовувати їх усі. Особливо це актуально для ознак корелювання. Наприклад, ознаки "Вік" і "Стаж роботи", по суті, несуть ту саму інформацію, тому один з них можна виключити.

Найбільш ефективним засобом скорочення числа ознак є факторний аналіз та метод основних компонентів.

Скорочення різноманітності значень ознак має сенс, наприклад, якщо точність уявлення даних надмірна і замість речових значень можна використовувати цілі без погіршення якості моделі. Але при цьому зменшиться об'єм пам'яті, що займається даними, і обчислювальні витрати.

Підмножина даних, отримане в результаті скорочення розмірності, має успадкувати від вихідної множини стільки інформації, скільки необхідно для вирішення задачі із заданою точністю, а обчислювальні та часові витрати на скорочення даних не повинні знецінювати отримані від нього переваги.

Аналітична модель, побудована на основі скороченої множини даних, має стати простіше для обробки, реалізації та розуміння, ніж модель, побудована на вихідній множині.

Рішення про вибір методу скорочення розмірності ґрунтується на апріорному знанні про особливості вирішуваного завдання та очікувані результати, а також обмеженість часових та обчислювальних ресурсів.

Машинне навчання - це не що інше, як область навчання, яка дозволяє комп'ютерам «вчитися», як люди, без потреби явного програмування.

Що таке прогнозоване моделювання:прогнозоване моделювання - це ймовірнісний процес, який дозволяє нам прогнозувати результати на основі деяких предикторів. Ці предиктори переважно є функціями, які входять у гру щодо остаточного результату, тобто результату моделі.

Що таке зменшення розмірності?

У завданнях класифікації машинного навчання часто дуже багато чинників, виходячи з яких робиться остаточна класифікація. Ці чинники переважно змінні, звані ознаками. Чим більше функцій, тим складніше візуалізувати тренувальний набір і працювати над ним. Іноді більшість цих функцій взаємопов'язані і, отже, є надмірними. Це де алгоритми зменшення розмірності вступають у гру. Зменшення розмірності — це зменшення кількості аналізованих випадкових величин шляхом отримання набору основних змінних. Це може бути поділено на вибір особливості та вилучення особливості.

Чому зменшення розмірності важливе у машинному навчанні та прогнозному моделюванні?

Інтуїтивно зрозумілий приклад зменшення розмірності можна обговорити за допомогою простого завдання класифікації електронної пошти, де необхідно визначити, чи є електронна поштаспамом чи ні. Це може включати велика кількістьфункцій, наприклад, чи має електронний лист загальний заголовок, зміст електронного листа, чи використовує електронний лист шаблон і т. д. Однак деякі з цих функцій можуть перекриватися, В іншому стані проблема класифікації, яка залежить як від вологості, так і від опадів, може бути зведена в одну основну характеристику, оскільки обидва з вищезгаданих корелюють високою мірою. Отже, ми можемо зменшити кількість функцій у таких завданнях. Проблему тривимірної класифікації важко уявити, тоді як двовимірну можна зіставити з простим двовимірним простором, а одномірну задачу — з простою лінією. Наведений нижче малюнок ілюструє цю концепцію, де тривимірний простір ознак поділяється на два одновимірні простори ознак, і пізніше, якщо виявлено, що вони корелюються, число ознак може бути зменшено ще більше.

Компоненти зменшення розмірності

Існує два компоненти зменшення розмірності:

- Вибір параметрів:у цьому розділі ми намагаємося знайти підмножина вихідного набору змінних або функцій, щоб отримати менше підмножини, які можна використовувати для моделювання проблеми. Зазвичай це включає три способи:

- Фільтр

- обгортка

- впроваджений

- Вилучення ознак:Це зменшує дані у багатовимірному просторі до нижчого виміру, тобто простору з меншим номером. розмірів.

Методи зменшення розмірності

Різні методи, що використовуються для зменшення розмірності, включають:

- Аналіз основних компонентів (PCA)

- Лінійний Дискримінантний Аналіз (LDA)

- Узагальнений дискримінантний аналіз (GDA)

Зменшення розмірності може бути як лінійним, і нелінійним, залежно від використовуваного методу. Основний лінійний метод, званий аналіз основних компонентів, або PCA, обговорюється нижче.

Аналіз основних компонентів

Цей метод було запроваджено Карлом Пірсоном. Він працює за умови, що хоча дані в просторі більш високого вимірювання відображаються в дані в просторі нижчого виміру, дисперсія даних в просторі нижчого виміру повинна бути максимальною.

Він включає наступні кроки:

- Побудувати коварійну матрицю даних.

- Обчислити власні вектори цієї матриці.

- Власні вектори, відповідні найбільшим власним значенням, використовуються відновлення великої частини дисперсії вихідних даних.

Отже, у нас залишилося менше власних векторів, і в процесі могла статися деяка втрата даних. Але найбільш важливі відхилення повинні зберігатися власними векторами, що залишилися.

Переваги зменшення розмірності

- Це допомагає у стисненні даних, і, отже, зменшує простір для зберігання.

- Це зменшує час обчислень.

- Це також допомагає видалити надлишкові функції, якщо такі є.

Недоліки зменшення розмірності

- Це може призвести до певної втрати даних.

- PCA має тенденцію знаходити лінійні кореляції між змінними, що іноді небажано.

- PCA зазнає невдачі у випадках, коли середнє значення та підступність недостатні для визначення наборів даних.

- Ми можемо не знати, скільки основних компонентів слід дотримуватися практично, застосовуються деякі правила великого пальця.

Ця стаття надана Ананней Уберой. Якщо ви як GeeksforGeeks і хотіли б зробити свій внесок, ви також можете написати статтю за допомогою contribute.geeksforgeeks.org або поштою статті [email protected]Дивіться свою статтю, що з'являється на головній сторінці GeeksforGeeks, та допоможіть іншим вундеркіндам.